Con muy poquitas modificaciones realizo ahora el seguimiento de dos puntos centrales de la imagen para calcular la rotación (balanceo) de la cámara.

El código de ejemplo es:

Con un par de modificaciones rápidas más (hardcoded) guardo las imágenes obtenidas en un vídeo AVI con FOURCC "XVID", 30 imágenes por segundo y con nombre de archivo "salida.avi". Lo ideal sería calcular la velocidad de cuadro real y/o enviar el mismo fotograma a la salida en caso de ralentización.

Ese tema lo dejaremos para más adelante.

El código de ejemplo modificado es:

En el siguiente vídeo puede observarse el seguimiento del horizonte realizado por el algoritmo.

Hay que recordar que no se hace corrección de perspectiva, por lo que si la webcam no sólo se rota (balancea) si no que se gira o cabecea, el cálculo del balanceo comienza a acumular errores. Por eso en el vídeo reinicio el horizonte en dos ocasiones.

Blog dedicado a CREAR conocimiento sobre robótica, electrónica, proporcionando las herramientas necesarias para que puedas "hacer tú mismo" tu propio robot :)

martes, 15 de febrero de 2011

lunes, 14 de febrero de 2011

Análisis del flujo de movimiento en OpenCV (y 2)

He realizado una pequeña modificación para mostrar el movimiento acumulado (y representado por la flecha roja central) mediante una cruz verde.

Aparentemente se sigue el movimiento del punto de la escena, pero sólo funciona si la escena se mueve al mismo tiempo sin rotación y sin que haya un objeto en el centro que se mueva.

El código de ejemplo es:

El resultado de un movimiento satisfactorio (sin rotación ni objetos en la zona central que interfieran) puede verse en el siguiente vídeo:

Pero si realizamos rotación de la webcam o pasamos un objeto por el centro de la escena (pero no delante del objeto perseguido) entonces el algoritmo falla, ya que la información la está obteniendo del centro de la pantalla y no del objeto rastreado:

La forma de arreglar este problema es sencilla. En vez de dejar fijo el punto del fotograma anterior al que queremos calcular el flujo de movimiento lo vamos actualizando al mismo punto donde se ha calculado el desplazamiento.

El código del ejemplo mejorado es:

En el siguiente vídeo se muestra cómo ahora el algoritmo es más robusto frente a la rotación de la imagen, al movimiento de objetos en la zona central, pero no a los movimientos de objetos frente al objeto rastreado:

Aparentemente se sigue el movimiento del punto de la escena, pero sólo funciona si la escena se mueve al mismo tiempo sin rotación y sin que haya un objeto en el centro que se mueva.

El código de ejemplo es:

El resultado de un movimiento satisfactorio (sin rotación ni objetos en la zona central que interfieran) puede verse en el siguiente vídeo:

Pero si realizamos rotación de la webcam o pasamos un objeto por el centro de la escena (pero no delante del objeto perseguido) entonces el algoritmo falla, ya que la información la está obteniendo del centro de la pantalla y no del objeto rastreado:

La forma de arreglar este problema es sencilla. En vez de dejar fijo el punto del fotograma anterior al que queremos calcular el flujo de movimiento lo vamos actualizando al mismo punto donde se ha calculado el desplazamiento.

El código del ejemplo mejorado es:

En el siguiente vídeo se muestra cómo ahora el algoritmo es más robusto frente a la rotación de la imagen, al movimiento de objetos en la zona central, pero no a los movimientos de objetos frente al objeto rastreado:

Etiquetas:

c,

flujo óptico,

gcc,

opencv,

visión artificial

viernes, 11 de febrero de 2011

Análisis del flujo de movimiento en OpenCV

Vamos a dar un salto brusco en la línea de aprendizaje para llegar al análisis del flujo de movimiento usando la librería de visión artificial OpenCV.

En este ejemplo (algo más complejo que los anteriores) usaremos tres imágenes temporales, el fotograma actual en color sobre el que dibujaremos líneas que representarán el flujo de movimiento y una copia del fotograma anterior y actual en escala de grises, y dos imágenes de trabajo para las dos pirámides necesarias para la implementación piramidal desarrollada por Jean-Yves Bouguet del algoritmo iterativo de seguimiento de características de imagen de Lucas-Kanade.

La función usada es cvCalcOpticalFlowPyrLK.

Tiene como parámetros de entrada los dos fotogramas sobre los que deseamos estudiar el flujo de movimiento (en escala de grises), las dos imágenes temporales (pirámides), una serie de puntos sobre los que deseamos averiguar el flujo de movimiento, el vector de movimiento resultante y el criterio de parada.

El código de ejemplo es (le faltan unos retoques):

Se puede experimentar con diversos criterios de parada (número máximo de iteraciones y error permitido). Si se alcanza el número máximo de iteraciones sin haber llegado a un resultado que se ajuste al error deseado la característica será marcada como no calculada. Esto suele ocurrir, sobre todo, cuando se trabaja con zonas de color liso o durante movimientos bruscos en los que el emborronado de movimiento de la cámara (o webcam) suaviza los detalles de la imagen haciéndolos irreconocibles desde el fotograma anterior.

Por otro lado, os recuerdo que una gran mayoría de webcams entregan los fotogramas en formato JPEG, por lo que para evitar que los artefactos cuadriculados de la compresión JPEG estorben en el análisis de movimientos debe usarse una apertura superior a 16 pixeles.

En este ejemplo (algo más complejo que los anteriores) usaremos tres imágenes temporales, el fotograma actual en color sobre el que dibujaremos líneas que representarán el flujo de movimiento y una copia del fotograma anterior y actual en escala de grises, y dos imágenes de trabajo para las dos pirámides necesarias para la implementación piramidal desarrollada por Jean-Yves Bouguet del algoritmo iterativo de seguimiento de características de imagen de Lucas-Kanade.

La función usada es cvCalcOpticalFlowPyrLK.

Tiene como parámetros de entrada los dos fotogramas sobre los que deseamos estudiar el flujo de movimiento (en escala de grises), las dos imágenes temporales (pirámides), una serie de puntos sobre los que deseamos averiguar el flujo de movimiento, el vector de movimiento resultante y el criterio de parada.

El código de ejemplo es (le faltan unos retoques):

Se puede experimentar con diversos criterios de parada (número máximo de iteraciones y error permitido). Si se alcanza el número máximo de iteraciones sin haber llegado a un resultado que se ajuste al error deseado la característica será marcada como no calculada. Esto suele ocurrir, sobre todo, cuando se trabaja con zonas de color liso o durante movimientos bruscos en los que el emborronado de movimiento de la cámara (o webcam) suaviza los detalles de la imagen haciéndolos irreconocibles desde el fotograma anterior.

Por otro lado, os recuerdo que una gran mayoría de webcams entregan los fotogramas en formato JPEG, por lo que para evitar que los artefactos cuadriculados de la compresión JPEG estorben en el análisis de movimientos debe usarse una apertura superior a 16 pixeles.

Etiquetas:

c,

flujo óptico,

gcc,

Lukas-Kanade,

opencv,

visión artificial

lunes, 7 de febrero de 2011

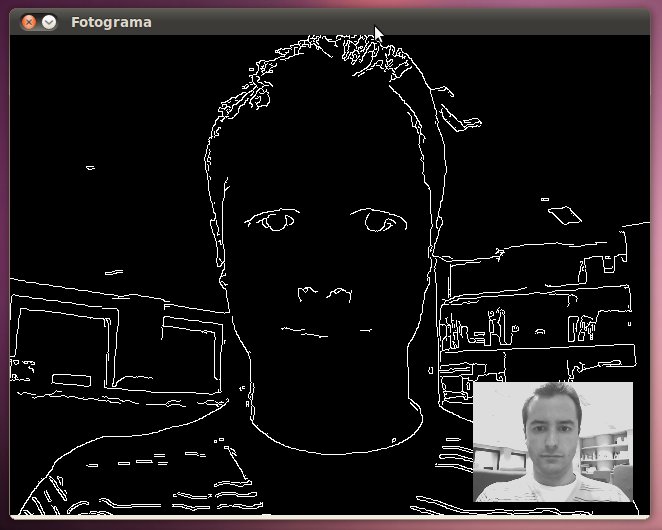

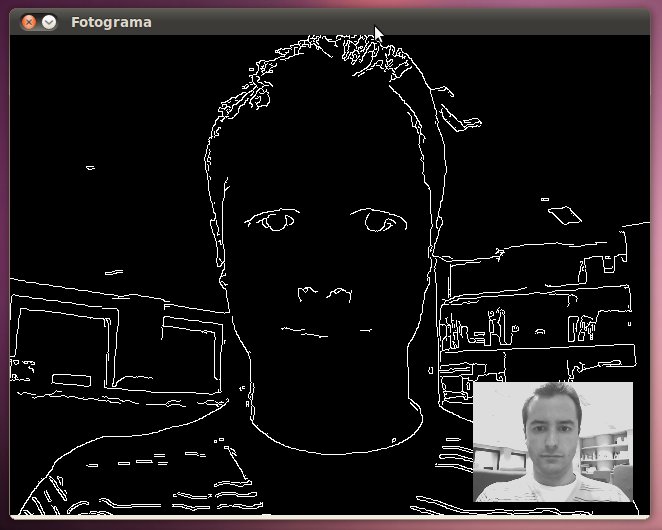

Filtro de detección de bordes (Canny) usando OpenCV

La detección de bordes, en procesamiento digital de imágenes, nos permite averiguar los contornos de la imagen o, mejor dicho, los cambios bruscos de intensidad lumínica. Es por esto último por lo que no se recomienda usar un filtro de detección de bordes tras haber suavizado con una amplitud grande una imagen a no ser que se use una apertura superior en el filtro Canny.

La función que realiza el filtro de suavizado de imagen en OpenCV es cvCanny.

El código fuente del ejemplo es:

El resultado obtenido tras ejecutar el código de ejemplo es:

La función que realiza el filtro de suavizado de imagen en OpenCV es cvCanny.

El código fuente del ejemplo es:

El resultado obtenido tras ejecutar el código de ejemplo es:

Etiquetas:

c,

canny,

filtro óptico,

gcc,

opencv,

visión artificial

Suscribirse a:

Comentarios (Atom)